3.7. Web Scraping

1 Übung · ca. 12 Minuten

Informationen sammeln und speichern

Web Scraping ist der automatisierte Prozess des Extrahierens von Daten aus Webseiten. Die Seiten werden dabei also nicht händisch von einem echten Besucher nach den relevanten Informationen durchsucht, sondern Programme oder Skripte versuchen anhand vordefinierter Regeln die gewünschten Inhalte zu finden und zu speichern.

Web-Scraping-Tools verwenden in der Regel HTTP-Requests, um auf Webseiten zuzugreifen und dann den HTML-Code zu analysieren, um relevante Daten herauszufiltern. Diese Daten werden anschließend in einer Datei oder Datenbank gespeichert und anschließend meist in Tabellen aufbereitet oder in Diagrammen visualisiert.

Zum Einsatz kommt das Verfahren in der Marktforschung, in der Überwachung von Wettbewerbern oder dem Extrahieren von Kontaktinformationen. Vielleicht möchtest Du aber auch überprüfen, ob auf allen Seiten einer Website das Tracking für Google Analytics korrekt integriert wurde oder wie viele Beiträge es in einem Blog von einem bestimmten Autoren gibt? Anwendungsfälle gibt es viele. Je fortgeschrittener Du im Umgang mit dem SEO Spider bist, desto eher fallen Dir sicher eigene Szenarien ein.

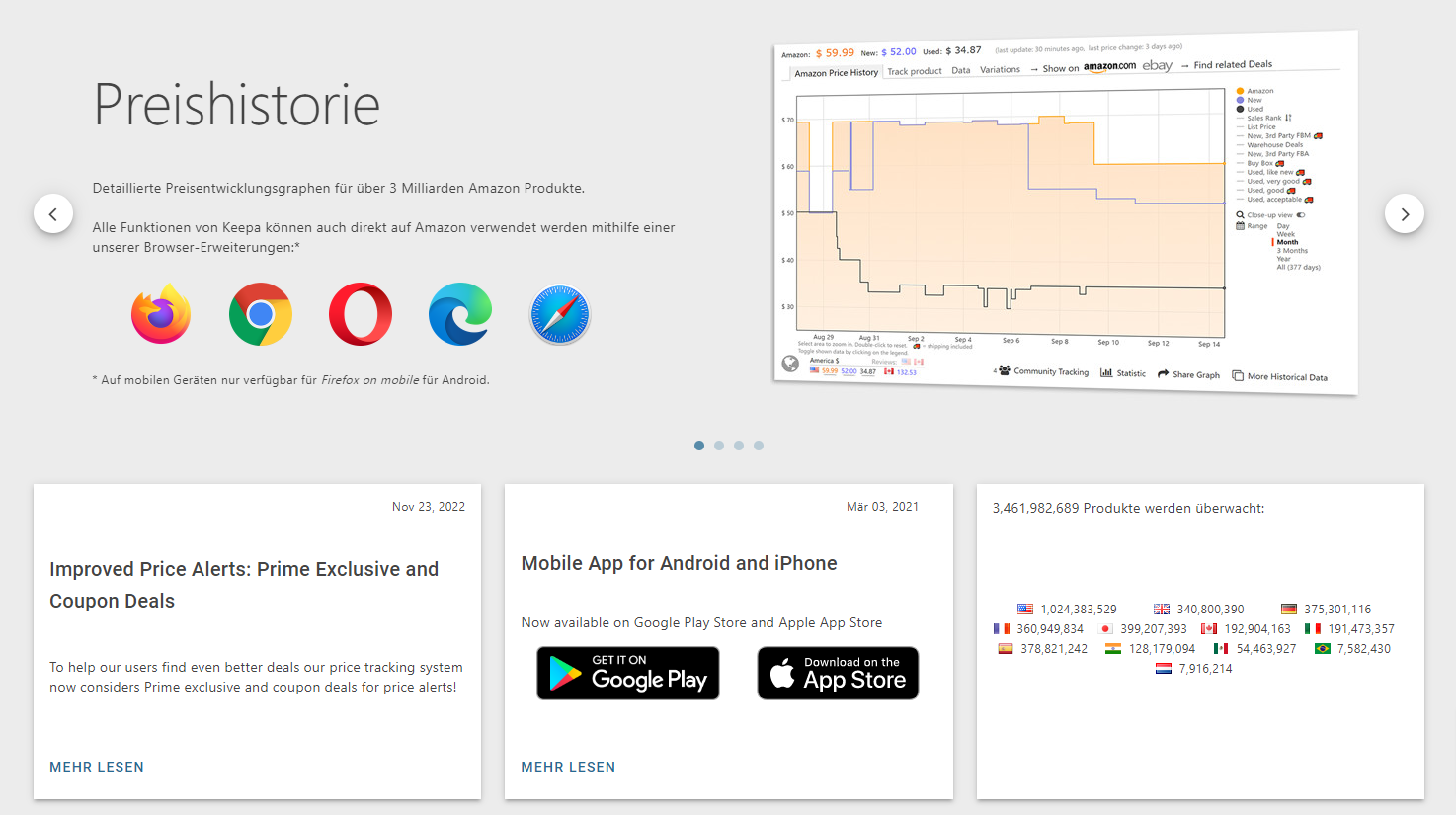

Populär sind beispielsweise auch Preis-Monitoring-Dienste wie die Browser-Extension Keepa. Mit ihr kann die Preisentwicklung von mehr als 3 Milliarden Produkten in Amazons Online-Shop nachverfolgt werden:

Wichtig: Web Scraping kann in einigen Fällen illegal sein. Es bleibt für jeden Einsatz zu prüfen, ob mit dem automatisierten Einsammeln der Daten gegen die Nutzungsbedingungen der betroffenen Website oder gegen geltende Gesetze (u.a. zum Datenschutz) verstoßen wird.

Weitere Informationen

Universität Hamburg – Handreichung zur rechtskonformen Durchführung Web-Scraping-Projekten

Forschung und Lehre – Grenzen des Web-Scrapings

Dury Legal – Webscraping, Screenscraping und das Datenbankurheberrecht

Du möchtest weiterlesen?

Du kannst Dich kostenlos registrieren und anschließend auf alle Inhalte im Online-Kurs zugreifen.

Du hast schon einen Account? Dann melde Dich an.