4.4. Google Looker Studio

1 Übung · ca. 10 Minuten

Daten sammeln, visualisieren und teilen

Google Looker Studio (bis Oktober 2022 Google Data Studio genannt) ist eine webbasierte Datenvisualisierungsplattform, die von Google kostenlos zur Verfügung gestellt wird. Looker Studio bietet eine Reihe an Verknüpfungen, um Daten aus verschiedenen Quellen auszulesen, miteinander zu verbinden und zu visualisieren.

Das Tool ermöglicht es, Berichte und Dashboards zu erstellen, die einfach zu verstehen und zu interpretieren sind. Es verfügt über eine Vielzahl von Funktionen, einschließlich Drag-and-Drop-Visualisierungstools, automatischer Datenaufbereitung und -modellierung sowie leistungsstarken Abfrage- und Analysefunktionen. Ein weiterer Vorteil: Looker Studio Reports können mit anderen Google-Usern geteilt und gemeinsam bearbeitet werden.

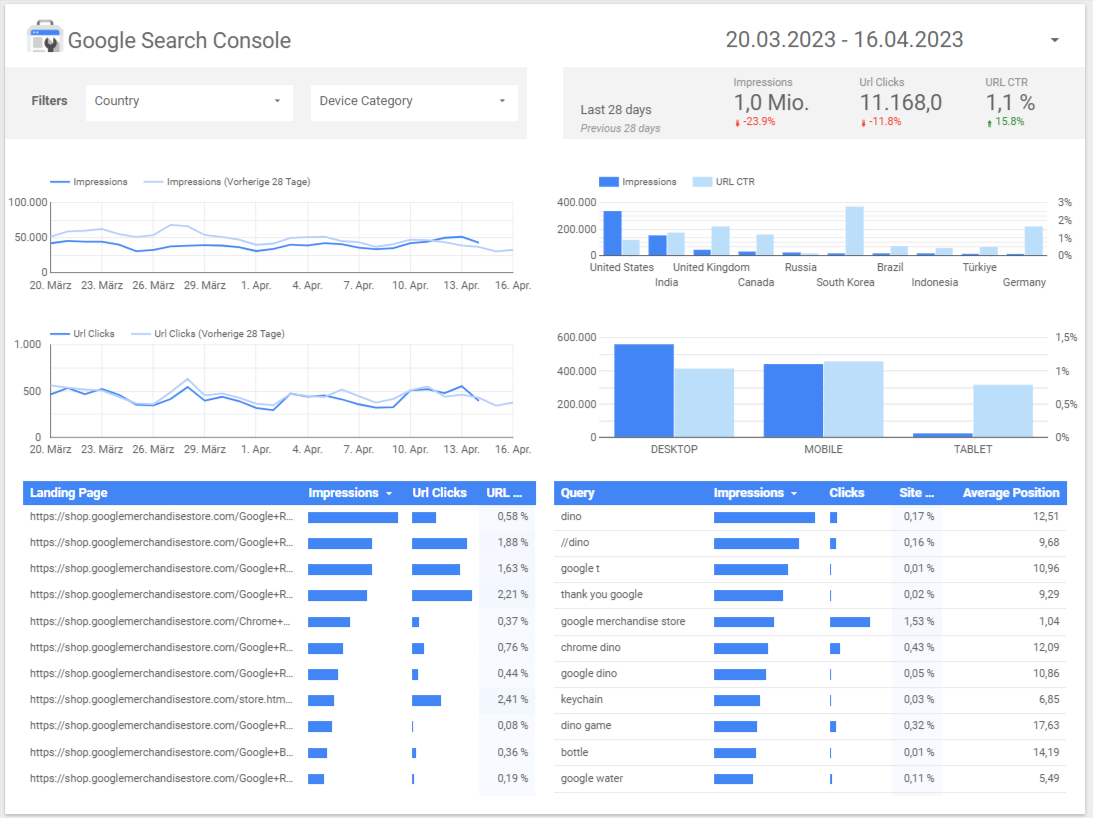

Die Plattform stellt dabei selbst keine Daten zur Verfügung, sondern erreicht ihren Anwendungszweck erst über die Anbindung externer Dienste (sogenannte Konnektoren – engl. Connectors), die dann Informationen zur Verfügung stellen. Datenquellen können dabei andere Google-Dienste wie Google Analytics, Google Ads oder die Google Search Console sein. Es können aber auch eigene Anbindungen umgesetzt oder bestehende Anbindungen von Drittanbietern genutzt werden. So stellt beispielsweise auch Sistrix einen eigenen Connector zur Verfügung, der es Kunden der Sistrix Toolbox erlaubt, ausgewählte Daten im Looker Studio zu verwenden.

Template für einen Search Console-Report in Looker Studio

Weitere Informationen

Google – Looker Studio

missing link – Datenvisualisierungen mit Googles Looker Studio

Sistrix – Google Looker Studio Connector

Du möchtest weiterlesen?

Du kannst Dich kostenlos registrieren und anschließend auf alle Inhalte im Online-Kurs zugreifen.

Du hast schon einen Account? Dann melde Dich an.