1.6. Ein erster Website-Crawl

1 Übung · ca. 9 Minuten

Den Crawl starten

Du hast den Screaming Frog SEO Spider erfolgreich installiert, Dich mit der Benutzeroberfläche etwas vertraut gemacht und die ersten Anpassungen in der Konfiguration vorgenommen? Jetzt kann es losgehen. Du startest Deinen ersten Website-Crawl.

Gib einmal die Homepage Deiner Website in das Feld URL zum Crawlen eingeben ein und klicke auf Start. Die eingegebene URL und alle URLs, die über Hyperlinks im HTML-Code von Seiten derselben Subdomain gefunden werden, werden nun gecrawlt und deren Daten zusammengetragen.

Die URL-Übersicht wird dabei in Echtzeit aktualisiert und kann bereits während des laufenden Crawls gefiltert werden.

Die Geschwindigkeit sowie die Gesamtzahl der abgeschlossenen und verbleibenden URLs können am unteren Rand des Programmfensters verfolgt werden.

Du kannst jederzeit auf Pause klicken und den Crawl zu einem späteren Zeitpunkt fortsetzen. Das kann mitunter sinnvoll sein, wenn Du parallel andere Arbeiten an Deinem Computer erledigen musst, denn der aktive Crawl kann die Performance enorm ausbremsen.

Aktiver Crawl

Während ein Crawl läuft, siehst Du nicht nur in der URL-Übersicht, sondern auch im Datenanalyse- und im Ergänzungsfenster, wie die Anzahl gesammelter Daten anwächst. Alle Einträge werden in Echtzeit aktualisiert. Das bedeutet aber auch, dass Du bereits während eines aktiven Crawls schon Details zu bereits erhobenen URLs ansehen kannst. Klickst Du eine Adresse in der URL-Übersicht an, bekommt Du die bis zum aktuellen Zeitpunkt erfassten Details dazu im URL-Detail-Fenster angezeigt.

Gerade bei größeren Websites ist es von Vorteil, wenn man bereits erste Auffälligkeiten einer bestimmten Seite oder Datei untersuchen kann, während weitere URLs durchsucht werden.

Wichtig: Der SEO Spider crawlt jede URL innerhalb eines Durchgangs nur einmal.

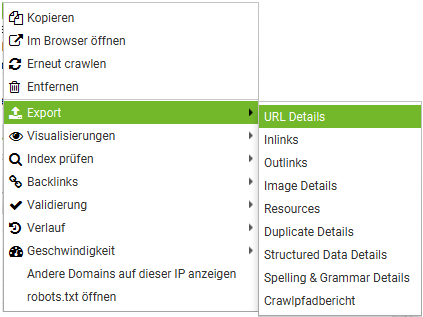

Wenn Du beispielsweise kurz nach dem Start des Crawls einen Fehler auf der Startseite in den URL-Details erkennst und diesen direkt behebst, wirst das keine Auswirkung auf die Anzeige des laufenden Crawls im Screaming Frog haben. Um zu testen, ob Deine Fehlerkorrektur erfolgreich war, musst Du entweder einen neuen Crawl-Durchgang über die gesamte Website starten oder explizit die von Dir bearbeitete URL in der URL-Übersicht auswählen. Ein Rechtsklick mit der Maus auf dieser Adresse öffnet ein Kontextmenü, in dem Du dann die folgende Option auswählst: Erneut crawlen.

Erhobene Daten sichten & exportieren

Die Daten eines Crawls können als CSV-, Excel- oder Googlesheet-Datei exportiert werden. Dazu klickst Du einfach auf die Schaltfläche Export in der URL-Übersicht. Für den nachfolgenden Export werden dann der aktive Tab und der gesetzte Filter berücksichtigt.

Du kannst aber auch Daten nur einer URL exportieren. Dazu hast Du zwei Möglichkeiten: Entweder klickst Du in der URL-Übersicht mit der rechten Maustaste auf die URL, aus denen Du Daten exportieren möchtest und wählst dort Export wählst im Untermenü einen der Tabs der URL-Übersicht.

Oder Du klickst eine URL in der Übersicht an und wählst die Schaltfläche Export oberhalb des URL-Detail-Fensters.

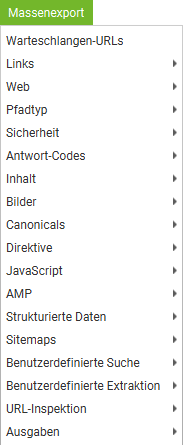

Im Hauptmenü findest Du außerdem den Punkt Massenexport. Hier verstecken sich weitere Reports, die als CSV, XLS, XLSX oder Gsheet exportiert werden können.

Der letzte Unterpunkt ist mit Ausgaben unglücklich übersetzt. Gemeint sind hier Probleme der gecrawlten Website. Wenn Du über Massenexport > Ausgaben > Alle einen Export anstößt, erhältst Du mitunter eine ganze Reihe an Reports. Für jede entdeckte Problemkategorie wir dann nämlich eine eigene Datei angelegt.

Crawl speichern

Wenn Du die kostenpflichtige Version des SEO Spiders einsetzt, hast Du zusätzlich die Möglichkeit, Deinen Crawl zu speichern und zu einem späteren Zeitpunkt wieder zu öffnen.

Wenn Du Dich dazu entschieden hast, Deinen Crawl im Arbeitsspeicher Deines Rechners durchzuführen, kannst Du ihn, wenn er pausiert oder beendet ist, unterhalb von Datei > Speichern unter… sichern und später unter Datei > Öffnen… erneut laden.

Wenn Du für Deinen Crawl festgelegt hast, dass er in einer Datenbank auf Deiner Festplatte abgelegt werden soll, findet die Speicherung bereits automatisch statt. Um einen solchen Crawl später wieder zu öffnen, klickst Du im Hauptmenü auf Datei > Crawls… (Der Menüpunkt ist auch nur sichtbar, wenn der SEO Spider im Datenbankspeichermodus läuft). Dort bekommst Du eine Übersicht der automatisch gespeicherten Crawls angezeigt. Du kannst hier nicht nur Crawls öffnen, sondern bestehende Crawls umbenennen, in Projektordnern organisieren, duplizieren, exportieren oder löschen.